Neue Welten entdecken – Big Data in der Teilchenphysik

Physikerinnen und Physiker aus dem Gebiet der Teilchenphysik erforschen, was die Welt im Innersten zusammenhält. Dafür erheben sie unglaubliche Datenmengen. Um mit den Daten arbeiten und daraus neue Erkenntnisse gewinnen zu können, müssen sie unter anderem ganz neue Methoden für Speicherung, Zugriff und Analyse entwickeln.

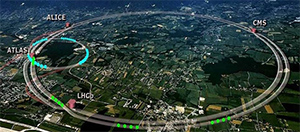

Physik-Experimente am CERN produzieren riesige Datenmengen.

Die erzeugten «Big Data» werden weltweit verteilt und verarbeitet.

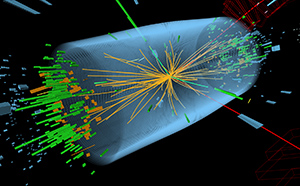

Entdeckt durch Datenanalyse: «Higgs Boson» (2012)

Die Forschung in der Teilchenphysik ist Grundlagenforschung, die das Wesen der Natur untersucht und die Strukturen von Raum, Zeit und Materie zu verstehen und zu beschreiben versucht. Die Forschenden sind dabei auf neueste Methoden angewiesen, die sie meist selbst entwickeln müssen, da sie entweder gar nicht oder noch nicht in der nötigen Genauigkeit existieren. Dabei kann es sich um neue Detektoren, Messgeräte, Materialien, aber auch um mathematische und statistische Methoden, oder auch um neue Softwarealgorithmen handeln.

Viele dieser Entwicklungen finden sich später im Alltag in Anwendungen wieder. Als Beispiele seien in der Medizin die bildgebenden Verfahren wie Röntgen, PET und MRI oder auch die verschiedenen Therapien genannt, wie z.B. die Bestrahlung von Tumoren. Auch die Entwicklung des World-Wide Webs geht auf Forscher am CERN zurück. Die Verarbeitung grosser Datenmengen ist dabei heute ein zentrales Thema der Teilchenphysik, wo schon früh Methoden wie GRID- oder Cloud-computing oder Virtualisierungen entwickelt und für die Forschung eingesetzt wurden.

Das CERN ist die weltweit wichtigste und grösste internationale Forschungseinrichtung für die Teilchenphysik. Auch Schweizer Physiker und Physikerinnen sind am Projekt «Large Hadron Collider (LHC)» beteiligt, wo pro Sekunde Millionen von Proton-Proton Kollisionen akribisch aufgezeichnet werden, um damit grundlegende Erkenntnisse zu gewinnen.

Die Analysen dieser «BIG Data» erlauben es, die mikroskopischen Strukturen von Materie zu untersuchen, und Bedingungen zu erzeugen, wie sie im frühen Universum vorherrschten, kurz nach dem «Big Bang». Einer der bisherigen Höhepunkte war die Entdeckung des «Higgs-Teilchens», das lange Zeit rein theoretisch vorhergesagt war. In der laufenden Forschungsperiode suchen die Forschenden in neuen, riesigen Datenmengen nach Hinweisen auf bisher unbekannte Phänomene der Teilchenphysik. Dabei werden in der Analyse modernste, statistische Methoden angewandt.

Die Daten werden mit einer Rate von ca. 10 PetaByte (PB) pro Monat aufgezeichnet, was mehr als einer Million Filme (DVD) entspricht. Die Analyse dieser riesigen Datenmengen nimmt über 300 PB an Disk- und 400 PB an Tape-Speicherplatz in Anspruch, was zusammen dem Speicherplatz von etwa einer Million PCs entspricht. Sie wird über ein weltweites Netzwerk von Computern durchgeführt, das sogenannte «LHC Computing Grid». Dieses Computer-Netzwerk umfasst über 150 Rechenzentren in 67 Ländern. Damit auf die Daten auch zeitnah und effizient zugegriffen werden kann, ist eine globale Daten-Transfer Rate von über 50 GByte/s realisiert; das entspricht in etwa der zehnfachen Datenmenge, die Facebook abspeichert.

Am Stand können Sie den ganzen Weg der Daten nachvollziehen: Von der experimentellen Messung über die Reduktion und Analyse bis hin zu den physikalischen Erkenntnissen, die Forschende daraus ableiten. Die Bewegung der Daten durch das internationale Netzwerk können Sie in Echtzeit nachverfolgen, und mehr über die internationale Zusammenarbeit der Physiker in der Datenverarbeitung erfahren. Anhand von Computer-Animationen und Poster erklären wir Ihnen, wie die Daten im Detail aufgezeichnet und analysiert werden.

Beteiligte

Prof. Dr. Christophorus Grab (ETH Zürich)

Prof. Dr. Florencia Canelli (UZH)